Articles Récents

Blind Deconvolution in Astronomy: How Does a Standalone U-Net Perform?

Extrait de « Blind Deconvolution in Astronomy: How Does a Standalone U-Net Perform? » (arxiv) dont le résumé est :

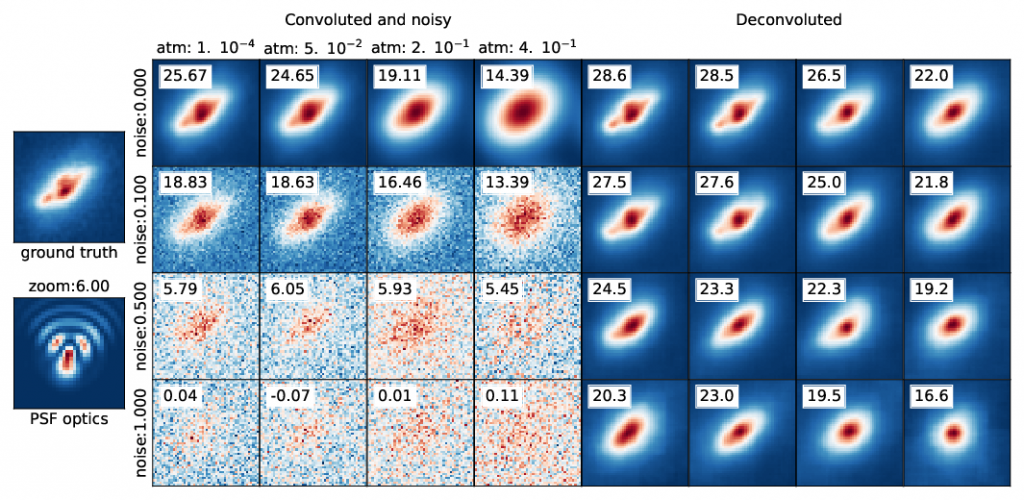

Aims: This study investigates whether a U-Net architecture can perform standalone end-to-end blind deconvolution of astronomical images without any prior knowledge of the Point Spread Function (PSF) or noise characteristics. Our goal is to evaluate its performance against the number of training images, classical Tikhonov deconvolution and to assess its generalization capability under varying seeing conditions and noise levels.

Methods: Realistic astronomical observations are simulated using the GalSim toolkit, incorporating random transformations, PSF convolution (accounting for both optical and atmospheric effects), and Gaussian white noise. A U-Net model is trained using a Mean Square Error (MSE) loss function on datasets of varying sizes, up to 40,000 images of size 48 × 48 from the COSMOS Real Galaxy Dataset. Performance is evaluated using PSNR, SSIM, and cosine similarity metrics, with the latter employed in a two-model framework to assess solution stability.

Results: The U-Net model demonstrates effectiveness in blind deconvolution, with performance improving consistently as the training dataset size increases, saturating beyond 5,000 images. Cosine

similarity analysis reveals convergence between independently trained models, indicating stable solutions. Remarkably, the U-Net outperforms the oracle-like Tikhonov method in challenging conditions

(low PSNR/medium SSIM). The model also generalizes well to unseen seeing and noise conditions, although optimal performance is achieved when training parameters include validation conditions. Experiments on synthetic Cα images further support the hypothesis that the U-Net learns a geometry-adaptive harmonic basis, akin to sparse representations observed in denoising tasks. These results align with recent mathematical insights into its adaptive learning capabilities.

Explication pour le grand public (French):

(conversation ludique simple, générée par NotebookLM, pas trop mal, bien que le trait soit un peu forcé qu’en même « à la mode américaine’.)

Galaxy Imaging with Generative Models: Insights from aTwo-Models Framework

Extrait de « Galaxy Imaging with Generative Models: Insights from aTwo-Models Framework » (arxiv:2503.23127, MNRAS) dont voici l’abstract:

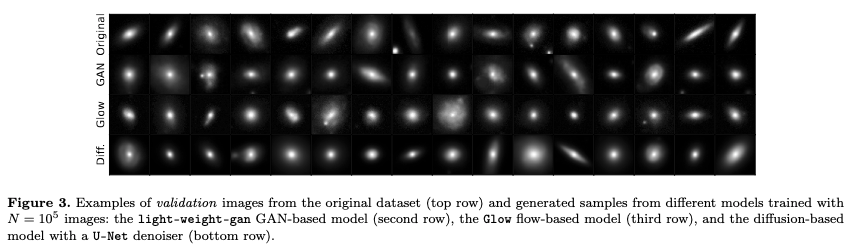

« Generative models have recently revolutionized image generation tasks across diverse domains, including galaxy image synthesis. This study investigates the statistical learning and consistency of three generative models: light-weight-gan (a GAN-based model), Glow (a Normalizing Flow-based model), and a diffusion model based on a U-Net denoiser, all trained on non-overlapping subsets of the SDSS dataset of 64 x 64 grayscale images. While all models produce visually realistic images with well-preserved morphological variable distributions, we focus on their ability to learn and generalize the underlying data distribution.

The diffusion model shows a transition from memorization to generalization as the dataset size increases, confirming previous findings. Smaller datasets lead to overfitting, while larger datasets enable novel sample generation, supported by the denoising process’s theoretical basis. For the flow-based model, we propose an « inversion test » leveraging its bijective nature. Similarly, the GAN-based model achieves comparable morphological consistency but lacks bijectivity. We then introduce a « discriminator test, » which shows successful learning for larger datasets but poorer confidence with smaller ones. Across all models, dataset sizes below O(105) pose challenges to learning.

Along our experiments, the « two-models » framework enables robust evaluations, highlighting both the potential and limitations of these models. These findings provide valuable insights into statistical learning in generative modeling, with applications certainly extending beyond galaxy image generation. »

Explication pour le grand public (French):

(générée par NotebookLM, pas trop mal avec quelques imprécisions mais l’idée générale y est bien décrite)

Carrière : chronologie en quelques étapes

- 2010-: Études en Cosmologie:

- Relevé optique auprès du grand télescope Vera Rubin Observatory: travail actuel dans les WGs de la collaboration DESC.

- Raie 21cm de l’hydrogène: j’ai participé aux programmes HI-Cluster au Radio-télescope de Nançay, et PAON2&4 à Nançay (R&D IDROGEN)

- Développements algorithmiques: Calcul non-Limber de spectre angulaire Angpow, Transformation Harmonique Sphérique Laguerre (LagSHT), AstroLabSoftware (usage de Spark en Astro), Broker FINK, Études des Réseaux de Neurones Profonds (en lien avec les cours de Stéphane Mallat, voir ci-après), Études de l’usage de la différentiation automatique et génération de chaines de Markov pour les méthodes bayésiennes (notamment en JAX). Participation aux librairies Core Cosmology Library et Jax-Cosmo , Jax-Galsim

- 2005-2010: Prospectives Oscillations de Neutrinos: Usines à Neutrinos (programme européen BENE), PMm2 R&D générique électronique innovante financée par l’ANR, LAGUNA projet européen d’étude de faisabilité d’un grand laboratoire souterrain en Europe (Cerenkov à eau, Argon Liquide, Scintillateur liquide).

- 1998-2005: Oscillations de Neutrinos (OPERA/CERN -> Gran Sasso), construction des grandes Cornes du CNGS au LAL

- 1990-1998: Double désintégration bêta avec et sans Neutrino NEMO/LAL

- 1988-1990: Expérience DELPHI au LEP/CERN: calucl des corrections radiatives dans les collisions e+e–

Travaux transverses

- Tutorials JAX accessibles sur Github, d’autres notebooks (ici) sont développés en JAX pour illustrer le cours de S.Mallat depuis 2022 (voir ci-après).

- Réseaux de Neurones Profonds. Depuis 2018 j’ai entrepris de rédiger des notes des cours de Stéphane Mallat, professeur au Collège de France, dont le thème général concerne les Sciences des données. Voici la liste des différents cours du Collège de France. Un repository GitHub est associé au cours depuis 2022. L’ensemble des notes depuis 2018 sont disponibles et mises à jour sur ce repository en Français et en Anglais. Voici la liste des leçons:

- 2025: Génération de données en IA par transport et débruitage

- 2024: Apprentissage et génération par échantillonnage aléatoire

- 2023: Modélisation, Information et Physique Statistique

- 2022: Théorie de l’Information

- 2021 : Représentations parcimonieuses

- 2020 : Modèles multi-échelles et réseaux de neurones convolutifs

- 2019 : L’apprentissage par réseaux de neurones profonds

- 2018 : L’apprentissage face à la malédiction de la grande dimension

Publications:

https://orcid.org/0000-0002-1590-6927

https://orcid.org/0000-0002-1590-6927

HAL , INSPIRE , Google Scholar, ResearchGate

Administration de la Recherche

- Président du Conseil Scientifique du Laboratoire Souterrain de Modane (2005-2009)

- Membre du CSTS Irfu/SPP de 2010 à 2013

Distinctions

- Médaille de Bronze du CNRS en 1996

- Prime d’excellence du CNRS en 2011